Álgebra linear/Imprimir

Wikilivristas que participaram do desenvolvimento e manutenção deste wikilivro:

- Albmont

- Dante

- Edudobay

- Felipe.sanches

- Helder

- João Jerónimo

- Jorge Morais

- LeonardoG

- Marcos Antônio Nunes de Moura

- Master

- Ozymandias

- Petrusz1

- Rodrigo Rocha

- Thiagoharry

- Thiago Marcel

Bem-vindo ao mundo da Álgebra Linear! Este livro foi escrito para ajudá-lo a compreender as complexidades e os conceitos fundamentais dessa área da matemática. Desde o estudo de sistemas de equações lineares até a análise de transformações lineares e diagonalização de matrizes, este livro irá guiá-lo em sua jornada de aprendizado de Álgebra Linear.

Com suas muitas aplicações em campos como matemática, ciência da computação, engenharia e física, a Álgebra Linear é uma das áreas mais importantes e úteis da matemática. Neste livro, você terá a oportunidade de explorar os conceitos fundamentais da Álgebra Linear de uma forma abrangente e detalhada. Ao longo das páginas, você aprenderá sobre espaços vetoriais, sistemas de equações lineares, determinantes, valores e vetores próprios, produtos internos e externos, e muitos outros tópicos. Cada capítulo contém explicações claras e concisas, exemplos ilustrativos e exercícios práticos para ajudá-lo a entender e praticar os conceitos.

Este livro apresenta uma abordagem didática e abrangente, com exemplos ilustrativos, exercícios e problemas práticos, além de explanações claras e concisas. Esperamos que, ao final da leitura, você tenha uma sólida compreensão dos conceitos e uma base sólida para prosseguir em sua jornada de estudos matemáticos. Boa leitura!

Este estudo de álgebra linear começará com a análise dos sistemas de equações lineares. Tais sistemas aparecem frequentemente em matemática aplicada, economia e engenharia ao modelar certos fenômenos. Por exemplo, em programação linear, geralmente é discutido como maximizar o lucro quando existem certas restrições relacionadas a dificuldade, disponibilidade de tempo, ou outras condições. Estas restrições podem ser colocadas na forma de um sistema de equações lineares.

Equações lineares

[editar | editar código-fonte]Uma equação linear é uma equação composta exclusivamente de adições e subtrações de termos que são constantes ou o produto de uma constante pela primeira potência de uma variável.

Conforme a natureza do problema que dá origem a equação, as constantes e as variáveis podem ser números inteiros, reais, complexos ou ter uma estrutura ainda mais geral (veja, por exemplo, um artigo sobre "corpos" na Wikipédia). No caso dos números inteiros, chama-se a equação de "equação linear diofantina", e seu estudo é feito na teoria de números.

Neste Wikilivro, será considerado que as constantes e as variáveis de uma equação linear são elementos de um subcorpo do corpo dos números complexos. Os elementos de serão chamados de escalares. Para a maior parte do texto, o leitor não familiarizado com corpos e outras estruturas algébricas pode admitir que os escalares são os números complexos.

Uma caracterização mais formal do que se entende por "equação linear" é a seguinte:

- Definição

Uma equação linear em variáveis sobre o corpo é uma equação que pode ser colocada na forma , sendo que os escalares são denominados coeficientes, e é chamado de termo independente, ou termo constante.

Cada equação linear pode ser vista como uma igualdade entre zero e um polinômio do primeiro grau em várias variáveis, uma vez que:

Como foi ressaltado no exemplo, para uma equação ser chamada de "linear", ela não precisa necessariamente estar com todas as variáveis no membro esquerdo da equação, embora seja usual escrevê-la assim. Como será visto posteriormente, usando essa convenção é possível simplificar a resolução de sistemas de equações lineares (veja adiante), introduzindo o conceito de matriz.

Soluções de uma equação linear

[editar | editar código-fonte]- Definição

Uma solução da equação linear é uma -upla (um vetor) , cujas entradas podem ser colocadas no lugar de cada , para , de modo que a igualdade seja verdadeira. O conjunto solução de uma equação linear é aquele formado por todas as suas soluções.

Por exemplo, é uma solução da equação linear , uma vez que , mas não.

No caso em que a quantidade de variáveis em uma equação linear é menor ou igual a três, pode-se associar ao seu conjunto solução, uma interpretação geométrica. Acompanhe os exemplos a seguir:

Pode-se generalizar a relação entre equações lineares e geometria para o caso em se tem um número arbitrário de variáveis. No entanto, nessa situação não é possível visualizar a "forma geométrica" que corresponde às soluções da equação. O termo utilizado para descrever a forma geométrica correspondente ao conjunto solução de uma equação a variáveis é hiperplano afim, de dimensão . Neste texto, no entanto, será usado simplesmente a terminologia -plano.

Sistemas de equações lineares

[editar | editar código-fonte]- Definição

Um sistema de equações lineares (ou sistema linear) é uma coleção de equações lineares envolvendo o mesmo conjunto de variáveis.

Um sistema geral de equações lineares com incógnitas (ou variáveis) pode ser escrito como

Aqui, são as incógnitas, são os coeficientes do sistema, e são os termos constantes.

A "chave" colocada à esquerda das equações é uma forma de lembrar que todas as equações devem ser consideradas em conjunto. A seguir são apresentados alguns exemplos de equações lineares.

Soluções de sistemas lineares

[editar | editar código-fonte]- Definição

Uma solução de um sistema linear é uma -upla de valores que simultâneamente satisfazem todas as equações do sistema.

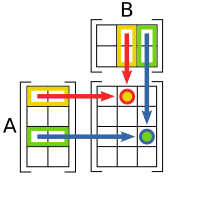

A coleção de todas as possíveis soluções de um sistema linear será chamada de conjunto solução, sendo geralmente denotado por . Uma fórmula que descreva todos os vetores do conjunto solução é chamada de solução geral. Dessa definição, decorre que o conjunto solução de um sistema linear é a interseção entre os conjuntos soluções de cada equação do sistema (veja a figura).

Um sistema linear é dito consistente se possui alguma solução. Caso contrário, é chamado de inconsistente.

Em geral, para qualquer sistema linear existem três possibilidades a respeito das soluções:

- Uma única solução: Neste caso, existe apenas uma solução específica (uma certa -upla). O conjunto tem um único elemento. Geometricamente, isto implica que os -planos determinados pelas equações do sistema se intersectam todos em um mesmo ponto do espaço, que é especificado pelas coordenadas da solução (as "entradas" da -upla). O sistema é dito possível (existe alguma solução) e determinado (existe uma única solução);

- Nenhuma solução: Nesta situação, não existe qualquer -upla de valores que verifiquem simultaneamente todas as equações do sistema. O conjunto é vazio. Geometricamente, os -planos correspondentes as equações não se intersectam (são paralelos). O sistema é dito impossível (não existe solução).

- Infinitas soluções: As equações especificam -planos cuja intersecção é um -plano onde . Sendo este o caso, é possível explicitar um conjunto com infinitas soluções. O sistema é dito possível (existe alguma solução) e indeterminado (sua quantidade é infinita)

As seguintes figuras ilustram os casos acima:

|

|

|

| Uma única solução | Nenhuma solução | Infinitas soluções |

Sistemas lineares equivalentes

[editar | editar código-fonte]- Definição

Dois sistemas lineares são ditos equivalentes quando possuem o mesmo conjunto solução.

Nos exemplos anteriores, pode-se notar que todos os sistemas possuem o mesmo conjunto solução (são equivalentes), embora no exemplo (V) a solução não esteja "tão evidente" como no caso de (I).

Isso sugere uma estratégia para resolver sistemas lineares: para determinar o conjunto solução de um sistema linear arbitrário (por exemplo (V)), basta encontrar um outro sistema linear que lhe seja equivalente, mas cuja solução seja imediata (como o (I), cuja solução é óbvia!).

Resta agora encontrar uma forma de produzir sistemas lineares equivalentes a um sistema dado, e que sejam simples (senão imediatos!) de resolver. As técnicas usadas para este fim serão apresentadas na próxima seção.

Operações com equações

[editar | editar código-fonte]Para um melhor entendimento das técnicas que podem ser utilizadas na resolução de sistemas lineares, serão sintetizadas no teorema a seguir as "operações" que podem ser feitas com as equações de um sistema, sem que seu conjunto solução seja alterado. Como será visto posteriormente, é possível determinar o conjunto solução de qualquer sistema linear (resolver o sistema), usando apenas três "operações elementares".

- Teorema

Se um sistema linear é obtido a partir de outro, através de uma dessas operações

- Trocar a posição de duas equações;

- Trocar uma equação por um múltiplo (não nulo) de si mesma;

- Trocar uma equação pela soma de si mesma com um múltiplo de outra equação;

Demonstração

[editar | editar código-fonte]- Deixada a cargo do leitor. Sinta-se a vontade para acrescentá-la ao texto.

Métodos para a resolução de sistemas lineares

[editar | editar código-fonte]Eliminação de variáveis

[editar | editar código-fonte]Um método bastante simples para a resolução de um sistema linear é eliminar as variáveis, uma após a outra. Este método consiste dos seguintes passos:

- Na primeira equação, isole uma das variáveis em função das outras.

- Substitua a expressão acima em cada uma das outras equações. Isso produz um outro sistema de equações, com uma equação a menos e uma variável a menos.

- Repita o passo anterior até que reste apenas uma equação linear.

- Resolva esta equação e use a resposta obtida para determinar as demais variáveis nas outras equações.

Sabe-se que sistemas lineares em poucas variáveis também podem ser resolvidos usando outros métodos.

Observe, no entanto, que estas técnicas não são muito práticas ao lidar com sistemas grandes, onde exista um grande número de variáveis. Apesar disso, tais procedimentos podem ser generalizados, dando origem a algoritmos como a eliminação de Gauss e a eliminação de Gauss-Jordan, que pode ser usado em situações bem mais gerais.

O método da eliminação gaussiana será estudado em um capítulo posterior.

Muitas vezes é preciso resolver vários sistemas lineares que diferem apenas em seus termos constantes. Os coeficientes das incógnitas permanecem os mesmos. Uma técnica chamada de decomposição LU é usada nestes casos. Em situações muito particulares, ela adminte uma variante conhecida como fatoração de Cholesky. Tais técnicas serão estudadas nos últimos capítulos.

Exercícios

[editar | editar código-fonte]Este capítulo é apenas uma revisão. Não há exercícios.

Esta página foi eleita pelos colaboradores como uma das melhores do Wikilivros. Para mais informações, consulte a página de votações.

| A distribuição do conteúdo deste livro está confusa ou pouco didática (discuta). Pede-se aos editores que reavaliem a distribuição do mesmo. |

| Este módulo tem a seguinte tarefa pendente: É preciso fixar a notação para as entradas das matrizes ao longo do livro, pois ora são usadas e ora para as entradas de uma matriz . |

Introdução

[editar | editar código-fonte]O termo matriz pode ser mais conhecido entre programadores e profissionais da informática, como sendo uma estrutura de dados. Em matemática, no entanto, matrizes são consideradas de forma bastante diferente.

Logo abaixo, apresenta-se uma matriz. A notação utilizada é bastante comum.

A matriz acima tem 4 linhas e 3 colunas, então pode ser chamada de matriz 4 × 3 (matriz 4 por 3). Além disso, pode-se ter matrizes de muitas formas diferentes. A forma de uma matriz é o nome das dimensões da mesma (m por n, quando m é o número de linhas e n é o número de colunas). A seguir são indicados alguns outros exemplos de matrizes, adotando outras possíveis notações.

Este é um exemplo de matriz 3 × 3:

Esta matriz tem a forma 5 × 4:

Aqui, tem-se uma matriz 1 × 6:

As matrizes são objetos matemáticos que além de permitirem uma boa organização espacial de conjuntos de dados numéricos, podem ser operadas com números (multiplicação por escalar) e com outras matrizes (sendo adicionadas, multiplicadas, etc). Entender as operações sobre matrizes é essencial para o aprendizado de Álgebra Linear.

Uma matriz é formada por linhas, que são conjuntos de dados dispostos horizontalmente e por colunas, conjuntos de dados dispostos verticalmente. Cada elemento presente em uma matriz é indicado por uma letra minúscula que possui como índice um par ordenado que representa o número da linha e o da coluna. Costuma-se representar total de linhas de uma matriz pela letra m e o número total de colunas por n. Os valores de m e de n são as dimensões da matriz.

Exemplos de matrizes

[editar | editar código-fonte]A matriz a seguir é uma matriz de ordem 2×3 com elementos naturais.

Nesse exemplo, o elemento é 2, o número na primeira linha e segunda coluna do quadro.

De forma geral, numa matriz A de ordem m × n, o elemento é o símbolo na i-ésima linha e j-ésima coluna de A. Assim:.

As entradas (símbolos) de uma matriz também podem ser definidas de acordo com seus índices i e j. Por exemplo, para de 1 a 3 e de 1 a 2, define a matriz 3×2

Abaixo, vemos o exemplo de uma Matriz Quadrada:

E agora um exemplo de uma Matriz Identidade:

Abaixo seguem informações sobre as principais operações definidas para matrizes. Abaixo matrizes serão representadas por letras maiúsculas e seus índices por letras minúsculas. Números escalares serão representados pela letra

Tipos especiais de matrizes

[editar | editar código-fonte]- Uma Matriz Quadrada é toda aquela na qual Isto é, ela possui o mesmo número de linhas e de colunas.

- Uma Matriz Linha é toda aquela na qual Isto é, ela possui apenas uma linha.

- Uma Matriz Coluna é toda aquela na qual Isto é, ela possui apenas uma coluna.

- Uma Matriz Diagonal é toda aquela na qual e cujo elemento se Isto é, possui todos os valores iguais à zero, exceto os elementos da diagonal principal.

- Uma Matriz Escalar é toda aquela na qual cujo elemento se e Isto é, todos os valores são nulos, exceto os valores da diagonal principal que possuem sempre o mesmo valor.

- Uma Matriz Nula é toda aquela cujos elementos Isto é, se todos os seus elementos forem nulos.

- Uma Matriz Identidade é toda aquela na qual cujos elementos se e se Isto é, possui todos os valores nulos, exceto os valores da diagonal principal que valem sempre 1.

Álgebra matricial

[editar | editar código-fonte]Multiplicação por um escalar

[editar | editar código-fonte]A multiplicação por um escalar é uma das operações mais simples que podem ser feitas com matrizes.

- Definição

Para multiplicar um número qualquer por uma matriz m×n basta multiplicar cada entrada de por Assim, a matriz resultante será também m×n e

Com isso, pode-se pensar também na noção de dividir uma matriz por um número: basta multiplicá-la pelo inverso desse número. Mas essa noção pode ser perigosa: enquanto a multiplicação entre um número e uma matriz pode ser dita "comutativa", o mesmo não vale para a divisão, pois não se pode dividir um número por uma matriz.

É impossível somar ou subtrair escalares de matrizes.

A multiplicação por escalar possui as seguintes propriedades:

- Associativa em relação ao Escalar:

- Distributiva em relação ao Escalar:

- Distributiva em relação à Matriz:

- Elemento Neutro:

Adição de Matrizes

[editar | editar código-fonte]A adição de matrizes é outra operação bastante simples.

- Definição

Sempre que uma matriz A é somada à uma matriz B, o resultado será uma matriz C, cujos elementos

Perceba que a operação de soma para matrizes de diferentes dimensões não é definida.

A adição de matrizes possui as seguintes propriedades:

- Propriedade Associativa:

- Elemento Neutro: ( é uma Matriz Nula, não um escalar)

- Simétrico Aditivo:

- Comutatividade:

Multiplicação de Matrizes

[editar | editar código-fonte]A multiplicação de duas matrizes é bem definida apenas se o número de colunas da matriz da esquerda é o mesmo número de linhas da matriz da direita.

- Definição

Se é uma matriz e é uma matriz então seu produto é a matriz (m linhas e p colunas) dada por:

- para cada par

A motivação dessa definição é a seguinte: se denota a -ésima linha da matriz podemos criar outra matriz cujas linhas sejam combinações lineares das linhas de

Em cada linha a entrada na -ésima coluna será uma combinação linear de todas as entradas de nessa mesma coluna:

mas corresponde a Então, se for a matriz com as entradas definidas como acima, obtemos a fórmula acima.

Da mesma maneira, se denota a -ésima coluna da matriz podemos criar uma matriz cujas colunas sejam combinações lineares das colunas de

E, tomando as entradas na -ésima linha, obtemos

Mas a a -ésima entrada à linha corresponde ao elemento de modo que também obtemos a fórmula acima.

Portanto,

Propriedades

[editar | editar código-fonte]A multiplicação de matrizes tem as seguintes propriedades:

- Associativa:

- Distributiva em relação à Adição:

- Elemento Neutro: se é uma matriz então

- onde representa a matriz identidade de ordem

Note que, em geral, a multiplicação de matrizes não é comutativa, ou seja, geralmente tem-se Em muitos dos casos, a multiplicação pode não estar sequer definida: quando existe a multiplicação a multiplicação só pode existir no caso em que e são quadradas; mesmo assim, ainda pode ocorrer a não-comutatividade.

Transposição

[editar | editar código-fonte]- Definição

A operação de transposição de uma matriz retorna como resultado sempre um matriz tal que, para todo elemento de e é então dita a matriz transposta de denotada por

- O número de linhas da matriz transposta será igual ao número de colunas da matriz original, assim como o número de colunas da transposta será igual ao número de linhas da original. Ou seja, se era será

- Cada coluna de corresponderá a uma linha de e vice-versa.

Notas

[editar | editar código-fonte]Ver também

[editar | editar código-fonte]- Matemática elementar/Matrizes (livro com conteúdo mais simples)

Em matemática, determinante é uma função matricial que associa a cada matriz quadrada um escalar; ela transforma essa matriz em um número real. Esta função permite saber se a matriz tem ou não inversa, pois as que não têm são precisamente aquelas cujo determinante é igual a 0.

Definição

[editar | editar código-fonte]Seja o conjunto das matrizes com n linhas e n colunas sobre um corpo k. Pode-se provar que existe uma única função com as seguintes propriedades:

- é n-linear e alternada nas linhas das matrizes;

- () onde é a matriz identidade.

Esta função denomina-se de determinante.

O determinante de uma matriz representa-se por ou por .

Matrizes 3x3

[editar | editar código-fonte]O determinante de matrizes de ordem 3 pode ser encontrado pela Regra de Sarrus, na qual a matriz é extendida repetindo as duas primeiras colunas, de modo que seja obtida uma sequência de 5 colunas. Em seguida, é somado os produtos das três diagonais principais (que partem de cima para baixo) e subtraído os produtos das três diagonais secundárias (que vão de baixo para cima). Seja a matriz de ordem 3 , o determinante pode ser dado por:

Cofator de uma matriz

[editar | editar código-fonte]É um número associado a um elemento qualquer de uma matriz quadrada. Compreender o cofator é um pré-requisito para o estudo do Teorema de La Place, que é comumente usada para calcular determinantes de ordem maior que três. Cada elemento possui o seu respectivo cofator, que é representado pela seguinte expressão:

O valor de é justamente o cofator do elemento . O ultimo termo diz respeito a determinante da matriz em questão sem os elementos da linha e da coluna .

Calcule o determinante usando cofatores:

|

Esta página é um esboço de matemática. Ampliando-a você ajudará a melhorar o Wikilivros. |

| A distribuição do conteúdo deste livro está confusa ou pouco didática (discuta). Pede-se aos editores que reavaliem a distribuição do mesmo. |

|

Esta página é um esboço de matemática. Ampliando-a você ajudará a melhorar o Wikilivros. |

Definição

[editar | editar código-fonte]Um espaço vetorial é formado por:

- Um conjunto qualquer cujos elementos serão chamados de vetores;

- Um corpo cujos elementos serão denominados escalares, com elementos neutros distintos 0 e 1;

- Uma operação conhecida como adição de vetores;

- Uma operação chamada de multiplicação por escalar.

Neste wikilivro, será escrito simplesmente para denotar

Normalmente, o corpo K é o corpo dos números racionais, dos números reais ou dos números complexos.

- Definição

Dizemos que é um espaço vetorial sobre quando as operações e satisfazem as seguintes propriedades:

- Adição

- Para cada (comutatividade)

- Para cada (associatividade)

- Existe um vetor tal que para cada (neutro aditivo)

- Para cada existe tal que (inverso aditivo)

- Multiplicação por escalar

- Para cada e cada (distributividade)

- Para cada e cada (distributividade)

- Para cada e cada (associatividade)

- Para cada (neutro multiplicativo)

Exemplos

[editar | editar código-fonte]- , e, mais geralmente, , são espaços vetoriais reais (sobre o corpo ), quando munidos da soma e multiplicação por escalar usuais.

- O conjunto formado pelo único número real 0, ou seja, {0}, é um espaço vetorial sobre

- é um espaço vetorial sobre

- Os exemplos acima são aplicáveis para qualquer corpo K, ou seja, são espaços vetoriais sobre K: {0}, K e Kn.

- Seja um número qualquer. O conjunto dos polinômios de grau menor ou igual a é um espaço vetorial, onde consideramos a soma de dois polinômios como a soma dos coeficientes de mesmo grau e a multiplicação por escalar como a multiplicação de cada coeficiente pelo escalar em questão.

- Seja o conjunto dos números inteiros positivos, e S o conjunto de todas as funções de domínio e contradomínio Dadas f e g funções e λ um número real, podemos definir

- (f + g) como a função que leva o número inteiro positivo n no número real f(n) + g(n)

- (λ f) como a função que leva o número inteiro positivo n no número real λ f(n).

Ou seja, foram definidas as operações de soma de vetores e produto de um escalar por um vetor em S. Como exercício, podem-se provar os axiomas, mostrando que S é um espaço vetorial. Este espaço vetorial é tão importante que tem um nome: ele é o espaço vetorial das sequências de números reais.

- O exemplo acima pode ser generalizado. Seja K um corpo qualquer, e I um conjunto qualquer (a letra I é porque este conjunto será chamado de conjunto de índices). Então o conjunto KI, das funções de domínio I e contra-domínio K, torna-se naturalmente um espaço vetorial definindo-se para

- O fato de um conjunto ser ou não um espaço vetorial depende fortemente das operações envolvidas. O próximo exemplo ilustra esta questão:

- Exemplo: Verifique se , munido das operações

- é um espaço vetorial.

- Com efeito, observe inicialmente que a a soma em questão é a usual. Logo, satisfaz as propriedades de espaço vetorial. Iremos provar que a a multiplicação por escalar não satisfaz o seguinte propriedade de espaço vetorial:

- De fato, se , então . Portanto, , munido destas operações, não é um espaço vetorial.

Subespaços vetoriais

[editar | editar código-fonte]Definição

[editar | editar código-fonte]Seja um espaço vetorial sobre o corpo Um subespaço vetorial de é um subconjunto que também é um espaço vetorial sobre com as mesmas operações (adição e multiplicação por escalar) de

Equivalentemente, um subespaço vetorial de é um subconjunto não-vazio fechado em relação às operações de adição e multiplicação por escalar, ou seja, um subconjunto tal que

- Para todos tem-se

- Para qualquer escalar e para todo tem-se

Exemplo: Seja . Provemos que é um subespaço vetorial.

- O subconjunto é não-vazio, uma vez que o vetor nulo pertence a .

- O subconjunto é fechado em relação à soma. Considere os vetores e abaixo: A soma desses dois vetores resulta no vetorO vetor resultante da soma de e ainda se encontra presente em , pois a segunda coordenada continua sendo o dobro da primeira e a terceira coordenada, o triplo da primeira.

- O subconjunto é fechado em relação à multiplicação por escalar. Considere novamente o vetor abaixo: A multiplicação de por um escalar resultará em: O vetor resultante dessa multiplicação ainda se encontra presente no subespaço , pois a segunda coordenada continua sendo o dobro da primeira e a terceira coordenada, o triplo da primeira.

Combinação linear

[editar | editar código-fonte]Definições

[editar | editar código-fonte]- Definição

Seja um espaço vetorial sobre um corpo Um vetor é dito combinação linear dos vetores se existem escalares tais que

Note-se que, pela definição, nem os λ nem os v precisam ser distintos.

- Definição

Seja S um subconjunto do espaço vetorial V. Um vetor é dito uma combinação linear de elementos de S quando ou existem:

- um número inteiro positivo n,

- vetores e

- escalares

Deve-se notar que a condição u = 0 é importante para o caso em que S seja o conjunto vazio. Equivalentemente, seria possível definir a soma de zero vetores como o vetor nulo (isto é semelhante à definição do fatorial de 0, igual ao produto de zero fatores, ou seja, é o elemento neutro multiplicativo, 1).

Propriedades

[editar | editar código-fonte]- Todo elemento x de S é uma combinação linear de elementos de S. Basta escolher n = 1, v1 = x e λ = 1, de forma que x = λ v1

- Se x é uma combinação linear de elementos de S, e λ é um escalar, então λ x também é uma combinação linear de elementos de S. Prova: x = 0 (neste caso, λ x = 0) ou Então

- Se x e y são combinações lineares de elementos de S, então x + y também é. A prova é um pouco mais complicada, e será feita com cuidado

- Caso x ou y sejam 0, é imediato que x + y, sendo igual a x ou y, é uma combinação linear de elementos de S.

- No caso geral, e Então definindo

e

temos que

- Os últimos resultados mostram que o conjunto formado por todas as combinações lineares de elementos de S é um espaço vetorial - o capítulo seguinte estudará este espaço

Dependência e Independência linear

[editar | editar código-fonte]- Definição

Seja um subconjunto de Dizemos que é linearmente dependente se existem vetores distintos e escalares não todos nulos, tais que

Quando temos um número finito de vetores é comum dizer que os vetores são linearmente dependentes (ou independentes), em vez de dizer que o conjunto é linearmente dependente (ou independente).

Propriedades

[editar | editar código-fonte]- Pela definição, o conjunto vazio é linearmente independente.

- Todo conjunto que contém o vetor nulo é linearmente dependente.

- Todo conjunto que tem um subconjunto linearmente dependente é linearmente dependente.

- Todo subconjunto de um conjunto linearmente independente é linearmente independente.

- Se um vetor de um conjunto é combinação linear de outros vetores desse conjunto, então o conjunto é linearmente dependente.

- A interseção de dois conjuntos linearmente independentes é linearmente independente - podendo ser o conjunto vazio.

- A interseção de um número qualquer de conjuntos linearmente independentes é linearmente independente.

- A união de conjuntos linearmente independentes, normalmente, não será linearmente independente. Porém quando um conjunto é subconjunto de outro, a sua união (sendo igual ao maior conjunto) é linearmente independente. Uma extensão não-trivial desta propriedade é a seguinte: seja K um conjunto formado por conjuntos linearmente independentes, de modo que dados quaisquer dois elementos de K, um deles é subconjunto do outro. Então a união de todos os elementos de K também é linearmente independente.

Espaço gerado

[editar | editar código-fonte]Definição

[editar | editar código-fonte]- Definição

Seja um subconjunto de um espaço vetorial O conjunto de todas as combinações lineares finitas de elementos de é um subespaço de e é dito o subespaço gerado por Quando é um conjunto finito dizemos que é o subespaço gerado pelos vetores

Exemplos

[editar | editar código-fonte]| Este módulo tem a seguinte tarefa pendente: Elaborar e incluir uma imagem para ilustrar este conceito. |

- Em qualquer espaço vetorial V, o espaço vetorial gerado pelo conjunto vazio é o subespaço vetorial { 0 }. Analogamente, o espaço vetorial gerado pelo conjunto V é o próprio V

- Em o espaço vetorial gerado por um vetor não-nulo é uma reta que passa pela origem

- Em o espaço vetorial gerado por um vetor não-nulo também é uma reta que passa pela origem

- Em o espaço vetorial gerado por dois vetores não-nulos, em que um deles não é múltiplo do outro, é todo o

- Em o espaço vetorial gerado por dois vetores não-nulos, em que um deles não é múltiplo do outro, é um plano que passa pela origem

Definição através de conjuntos

[editar | editar código-fonte]Seja S um conjunto de vetores de V. Pode-se perguntar qual é o menor subespaço vetorial de V que contém S. Para ser mais preciso, temos o seguinte:

- V é um subespaço vetorial de V que contém S

- A interseção de subespaços vetoriais de V que contém S também é um subespaço vetorial de V

Ou seja, seja K o conjunto (não vazio, porque ) definido por:

e seja definido por:

Teorema

[editar | editar código-fonte]Nas condições definidas acima, é o subespaço vetorial gerado por S.

Bases

[editar | editar código-fonte]- Definição

Seja um subconjunto de um espaço vetorial é uma base do espaço vetorial quando o subespaço de gerado por é o próprio e é um conjunto linearmente independente. Quando uma base é um conjunto finito de elementos, dizemos que tem dimensão .

Seja V um espaço vetorial e B uma base de V. Suponha que um vetor seja escrito como combinação linear de vetores de B de duas formas diferentes: O que pode ser dito a respeito dos λ e μ? O que pode ser dito a respeito dos ui e wj? A resposta é que, de certa maneira, eles são únicos.

Coordenadas

[editar | editar código-fonte]- Definição

Seja B uma base de um espaço vetorial V. Se existe então para todo vetor se expressarmos v como uma combinação linear de elementos de B que inclua b, o coeficiente do termo b será constante. Em outras palavras, para toda base B do espaço vetorial V existe uma função que associa a cada par um escalar. Esta função é chamada de a coordenada de v na base B

Ver também

[editar | editar código-fonte]Wikipédia

[editar | editar código-fonte]| A distribuição do conteúdo deste livro está confusa ou pouco didática (discuta). Pede-se aos editores que reavaliem a distribuição do mesmo. |

|

Esta página é um esboço de matemática. Ampliando-a você ajudará a melhorar o Wikilivros. |

Transformações Lineares

[editar | editar código-fonte]Definição

[editar | editar código-fonte]- Definição

Uma função onde e são espaços vetoriais sobre um corpo é dita uma transformação linear se, para todos e para todo tem-se

Existência de uma transformação

[editar | editar código-fonte]Sejam V e W espaços vetoriais sobre um corpo K, onde a . Seja uma base de V e vetores quaisquer de W. Então existe uma transformação linear .

| Prova |

|---|

|

Imagem de uma transformação linear

[editar | editar código-fonte]A seguir será discutido um exemplo de como achar a imagem de uma transformação linear. Considere , definida por . O valor de em um ponto pode ser reescrito da seguinte forma:

- .

Consequentemente, todo ponto da imagem é uma combinação linear dos vetores e , isto é, tais vetores formam um conjunto de geradores para a imagem de . Como poderá ser verificado pelo leitor[1], estes vetores também são linearmente independentes, constituindo portanto uma base para a imagem de .

Núcleo

[editar | editar código-fonte]- Definição

Seja uma transformação linear entre os espaços vetoriais V e W. O núcleo da transformação linear, Ker(T), é a imagem inversa do vetor nulo em W:

Teorema do núcleo

[editar | editar código-fonte]O núcleo de uma transformação linear é um subespaço vetorial do seu domínio

A demonstração é simples:

- Ker(T) não é vazio, pois 0V é um elemento de Ker(T), já que T(0V) = 0W

- Se então T(v) = T(w) = 0, logo, pela linearidade de T, T(v + w) = 0 e

- Se e temos logo ou seja,

Posto e nulidade

[editar | editar código-fonte]Se , e

- O posto(T) = dim Im(T),isto é, a dimensão da imagem de T(V), isto é, a quantidade de vetores L.I. que geram toda a imagem de T(V).

e

- A Nulidade(T) = dim Ker(T), isto é, é a dimensão do núcleo de T(V), isto é, a quantidade de vetores L.I. que geram todo o núcleo de T(V).

Teorema do posto e da nulidade

[editar | editar código-fonte]Sejam V e W espaço vetoriais sobre o corpo K e . Se , então posto(T) + Nulidade(T) = dim V

Prova

- Definindo a base do núcleo e a base do espaço:

Seja uma base do Ker(T). Existem vetores com j=k+1,...,n onde é uma base de V.

- Definindo a base da imagem:

Como é a base de V, T aplicada nessa base gera um conjunto que gera a imagem de T por V. Aplicando T sobre os vetores da base de V, temos , mas , pela definição de núcleo. Assim os vetores geram a imagem de T(V).

- Provando que os vetores são independentes:

Como queremos uma base, eles devem ser independentes, isto é, devem tal que .

Tomemos . Logo . Como .

Portanto . Como são L.I., então .

- Definindo posto e nulidade:

O Posto(T) = dim Im(T). Como geram a imagem de T(V), logo o posto(T)= n - (k+1) +1 = n-k.

A nulidade (T) = dim Ker(T). Como é uma base do Ker(T), logo a Nulidade (T)= k - 1 + 1 = k

Como n = dim V, Nulidade(T)=k e Posto(T)=n-k, portanto Posto(T) + Nulidade(T) = dim(V).

Funcionais lineares

[editar | editar código-fonte]Definição

[editar | editar código-fonte]- Definição

Uma função onde V é um espaço vetorial sobre K, é chamada de funcional linear se, e

- Teorema (existência e unicidade)

Se V é um espaço vetorial de dimensão n e é uma base de V, então existe um único funcional f, tal que e

- Teorema (base dual)

Se V é um espaço vetorial, e é uma base de V, então existe uma única base de tal que

- Definição

- é chamada de base dual de

- é chamado de espaço dual de V

Corolários:

Teoremas

[editar | editar código-fonte]- Teorema (representação dos funcionais lineares)

Sejam V um espaço vetorial sobre K, com produto interno, e um funcional linear. Então existe um único vetor tal que

Demonstra-se ainda que

Operador linear

[editar | editar código-fonte]Dizemos que T uma transformação linear, é chamada operador linear de T sobre V.

Adjunto de um operador linear

[editar | editar código-fonte]Definição

[editar | editar código-fonte]- Definição

Seja V um espaço vetorial. O operador adjunto, de um determinado operador linear é definido pela igualdade:

Demonstra-se que todo operador linear possui um e apenas um operador adjunto correspondente.

A partir da definição, podemos obter as seguintes conseqüências (prove!):

- Proposição

Seja V um espaço vetorial sobre K, com produto interno. Seja uma base ortonormal de V. Então onde

- Corolário

Seja V um espaço vetorial sobre K, com produto interno. Então, para qualquer base ortonormal de V, temos que a matriz

Operadores especiais

[editar | editar código-fonte]- Auto-adjunto ()

- Unitário ()

- Normal ()

Operador auto-adjunto

[editar | editar código-fonte]- Definição

é chamado de auto-adjunto se

Uma matriz A é auto-adjunta se

- Se é chamada simétrica.

- Se é chamada hermitiana.

Os seguintes enunciados são úteis na prova de teoremas do operador auto-adjunto:

- Se então

- Se V é complexo e então

Prove:

- Se e então

- Seja com V complexo. Então

Operador unitário

[editar | editar código-fonte]- Definição

é chamado de unitário se

Uma matriz A é unitária se

Prove:

- T é unitário (T preserva o produto interno)

- T é unitário (T preserva a norma)

- T é unitário é unitário

Operador normal

[editar | editar código-fonte]- Definição

é chamado de normal se

Uma matriz A é normal se

Prove:

- Todo operador auto-adjunto é normal

- Todo operador unitário é normal

É importante ressaltar, ainda, que existem operadores normais que não são unitários nem auto-adjuntos.

Subespaço invariante

[editar | editar código-fonte]Definição

[editar | editar código-fonte]- Definição

W, subespaço vetorial de V, é dito invariante sob o operador se

Dizemos também que W é T-invariante.

Exercícios

[editar | editar código-fonte]Prove:

- Se W é T-invariante, então é -invariante.

- Se W é T-invariante e T é auto-adjunto, então W é -invariante.

- Se W é T-invariante e T é inversível, então

- Se W é T-invariante e T é inversível, então W é -invariante e

- Se W é T-invariante e T é unitário, então W é -invariante (ou -invariante).

- Se W é T-invariante e T é unitário, então é T-invariante.

Notas

[editar | editar código-fonte]- ↑ Ver por exemplo no Wolfram Alpha

Ver também

[editar | editar código-fonte]Wikipédia

[editar | editar código-fonte]Álgebra linear

[editar | editar código-fonte]Seja A, uma álgebra linear sobre o corpo K, então A é um espaço vetorial com uma operação extra, que é multiplicação de vetores, que onde dois vetores u, v de A são levados ao vetor uv de A, que é o produto dos vetores u e v. As propriedades desse produto são:

- multiplicação é associativa: u(vw) = (uv)w.

- multiplicação é distributiva em relação à adição: u(v + w) = uv + uw(à esquerda) e (u + v)w = uw + vw(à direita).

- multiplicação por escalar: k(uv) = (ku)v = u(kv).

Extensões de uma álgebra linear

[editar | editar código-fonte]- com elemento unidade: se existir um elemento i em A, tal que iu = ui = u, para todo u em A

- comutativa: se uv = vu para todo u,v em A

Álgebra dos polinômios

[editar | editar código-fonte]Seja P[x] o espaço dos polinômios finitos, gerados pelos vetores , pata algum n inteiro qualquer. P[x] é um polinômio sobre o corpo K.

- Definição da elemento de P[x].

- onde .

- grau de p(x) em P[x]:

- , usando o p definido acima.

- coeficientes de p(x):

- são chamados os coeficientes do polinômio p(x).

- polinômio nulo:

- .

- polinômio não-nulo:

- .

- polinômio unitário:

- Se , então p(x) é unitário.

Teoremas

[editar | editar código-fonte]Propriedade do Grau do produto de polinômios

[editar | editar código-fonte]Sejam p, q em P[x]-{0} sobre K. Então:

- pq é um polinômio não-nulo.

- gr(pq)=gr(p)+gr(q).

- se p,q são unitários, então pq é unitário.

- pq é polinômio constante pq são polinômios constantes.

Ideais de polinômios

[editar | editar código-fonte]Lema

[editar | editar código-fonte]Sejam p,q em P[x]-{0} sobre K, onde . Logo existe r em P[x] tal que p-qr=0 ou gr(p-qr)<gr(p).

Autovetores e autovalores

[editar | editar código-fonte]- Definição

Seja V um espaço vetorial sobre K, e seja T um operador linear sobre V. Um vetor não nulo de V é dito um autovetor (ou vector próprio) de T se existir um tal que . Neste caso, é dito autovalor (ou valor próprio) de T.

Um significado prático:

- Os autovetores são vetores que, sob a ação de um operador linear, resultam num vetor de mesma direção. Os autovetores estão sempre ligados ao operador linear, ou seja, cada operador linear admite um conjunto específico de autovetores.

- Para cada autovalor , podem existir vários autovetores tais que . Dizemos que esses são autovetores associados ao autovalor . Haverá infinitos autovetores associados a cada autovalor, exceto no caso do corpo K ser um corpo finito.

Prove:

- Se v é um autovetor de T associado ao autovalor , e é um escalar não-nulo, então também é um autovetor associado a .

- O conjunto é um subespaço vetorial de V (ele é chamado de autoespaço). Note que é o conjunto de todos os autovetores associados a unido ao vetor nulo.

: um operador importante

[editar | editar código-fonte]O operador , leva os autovetores no vetor nulo

Como . Logo é o núcleo da transformação de .

Teorema do operador

[editar | editar código-fonte]Seja um operador linear sobre V de dimensão finita e um valor característico do operador T sobre V. O operador é singular, se e somente se, det()=0.

Prova:

- Definindo uma matriz associada ao operador

O operador é singular, ou seja, não é injetor. Existe uma matriz é a base do operador T sobre V. Assim tome , ou seja, .

- calculando a determinante sobre o polinômio

Autovetores de uma matriz quadrada

[editar | editar código-fonte]- Definição

Um autovalor de uma matriz é um escalar tal que existe um vetor não nulo v, com , onde v é chamado de autovetor de A associado a .

Polinômio característico

[editar | editar código-fonte]- Definição

Seja A uma matriz quadrada de ordem n. O polinômio é chamado de polinômio característico de A.

Prove:

- Seja uma base de V, e v um autovetor de T associado ao autovalor . Então é um autovetor da matriz associado ao autovalor de

- Se e são duas bases quaisquer de V, então o polinômio característico de é igual ao polinômio característico de .

Exemplo:

Operador diagonalizável

[editar | editar código-fonte]- Definição

Um operador T é dito diagonalizável se existir uma base de V tal que é uma matriz diagonal.

- Definição

Duas matrizes quadradas de mesma ordem, A e B, são ditas semelhantes se existir uma matriz P, de mesma ordem, inversível, tal que .

- Definição

Uma matriz é dita diagonalizável se for semelhante a uma matriz diagonal D (ou seja, existe uma matriz P, inversível, tal que ).

Prove:

- Se são autovetores de T associados, respectivamente, aos autovetores tais que se , então é LI.

- Seja uma base de V. A matriz é diagonal é uma base de V formada por autovetores de T

- Se T é auto-adjunto e é um autovalor de T, então .

- Se T é auto-adjunto e são autovetores de T associados aos autovalores (distintos), respectivamente, então , se .

- Se T é unitário e é um autovalor de T, então .

- Se é um autovalor de T e T é normal, então é autovalor de .

- é T-invariante.

- é -invariante.

- Se T é normal e é autovalor de T, então é -invariante.

- Se T é normal, então é T-invariante.

Em Álgebra linear, chamamos de produto interno uma função de dois vetores que satisfaz determinados axiomas. O produto escalar, comumente usado na geometria euclidiana, é um caso especial de produto interno.

Definição

[editar | editar código-fonte]Seja V um espaço vetorial sobre um corpo K. Em V, pode-se definir a função binária (denominada produto interno), que satisfaz os seguintes axiomas:

- Se , então >

em que u, v e w são vetores de V, e λ é um elemento de K.

A partir desses axiomas, é possível provar as seguintes consequências:

- Se , então

- Se , então

Exemplos

[editar | editar código-fonte]O produto escalar sobre o espaço vetorial satisfaz os axiomas do produto interno e é definido por:

Se f e g são duas funções contínuas em um intervalo fechado, é possível definir o produto interno:

Vetores ortogonais

[editar | editar código-fonte]Diz-se que dois vetores são ortogonais se .

Consequências (prove!):

- Se , então

- Se , então

Complemento ortogonal

[editar | editar código-fonte]Seja

Define-se o complemento ortogonal de v, , como:

Consequências (prove!):

- é um subespaço vetorial de V

- Seja um subespaço vetorial de V, e uma base de .

- , W é subespaço de V.

Norma

[editar | editar código-fonte]Seja V um espaço vetorial sobre o corpo K, com produto interno. Define-se a norma ou comprimento de um vetor como sendo o número , que indicamos por .

Consequências (prove!):

- Se , então

- Se , então (Teorema de Pitágoras)

Projeção ortogonal

[editar | editar código-fonte]Projeção de um vetor v na direção de um vetor u, em que u ≠ 0

[editar | editar código-fonte]Define-se essa projeção como sendo o vetor

Projeção de um vetor v sobre um subespaço vetorial W de V

[editar | editar código-fonte]Seja , em que é uma base ortogonal de W.

Desigualdade de Cauchy-Schwarz

[editar | editar código-fonte]Dados , então

Desigualdade triangular

[editar | editar código-fonte]

Base ortogonal e ortonormal

[editar | editar código-fonte]Uma base de V é dita ortonormal se , em que

- , se i = j

- , se i ≠ j

A base é ortogonal se os vetores são ortogonais dois a dois.

v1.v2=0

Propriedade: n vetores não-nulos e ortogonais dois a dois, em um espaço de dimensão n, são linearmente independentes.

Processo de ortogonalização de Gram-Schmidt

[editar | editar código-fonte]Dada uma base de V, podemos encontrar, a partir desta base, uma base ortogonal de V.

Distância entre dois vetores

[editar | editar código-fonte]Define-se a distância entre dois vetores quaisquer, u e v, como sendo

Uma função distância tem as seguintes propriedades:

Tais propriedades podem ser facilmente verificadas pela definição de norma.

Melhor aproximação de um vetor v de V por um vetor de W, subespaço vetorial de V

[editar | editar código-fonte]Se , então u é o vetor de W que dá a aproximação mais adequada de v por um vetor de W.

Demonstra-se que

Ver também

[editar | editar código-fonte]Formas bilineares

[editar | editar código-fonte]- Definição

Uma função g do produto cartesiano (onde V é um espaço vetorial de dimensão finita sobre o corpo K) é dita bilinear se, :

Matriz associada a uma forma bilinear

[editar | editar código-fonte]Sejam uma forma bilinear, e uma base de V. Sejam X e Y dois vetores de V, sob a forma de matriz coluna:

Então:

,

onde A é a matriz associada à forma bilinear g.

A matriz A é dada por:

onde

Formas bilineares simétricas

[editar | editar código-fonte]- Definição

Uma forma bilinear é dita simétrica se

Proposição: é uma forma bilinear simétrica se, e somente se, a matriz associada à forma bilinear é simétrica em qualquer base de V.

Formas quadráticas

[editar | editar código-fonte]- Definição

Dada uma forma bilinear simétrica , dizemos que a função , definida por , é a forma quadrática associada à forma bilinear g.

Note que:

Fórmulas de polarização

[editar | editar código-fonte]As fórmulas de polarização permitem que, dada a forma quadrática f, se descubra a forma bilinear g que a originou. Eis duas dessas fórmulas:

Autovetores e autovalores

[editar | editar código-fonte]- Definição

Seja V um espaço vetorial sobre K, e seja T um operador linear sobre V. Um vetor não nulo de V é dito um autovetor (ou vector próprio) de T se existir um tal que . Neste caso, é dito autovalor (ou valor próprio) de T.

Um significado prático:

- Os autovetores são vetores que, sob a ação de um operador linear, resultam num vetor de mesma direção. Os autovetores estão sempre ligados ao operador linear, ou seja, cada operador linear admite um conjunto específico de autovetores.

- Para cada autovalor , podem existir vários autovetores tais que . Dizemos que esses são autovetores associados ao autovalor . Haverá infinitos autovetores associados a cada autovalor, exceto no caso do corpo K ser um corpo finito.

Prove:

- Se v é um autovetor de T associado ao autovalor , e é um escalar não-nulo, então também é um autovetor associado a .

- O conjunto é um subespaço vetorial de V (ele é chamado de autoespaço). Note que é o conjunto de todos os autovetores associados a unido ao vetor nulo.

Autovetores de uma matriz quadrada

[editar | editar código-fonte]- Definição

Um autovalor de uma matriz é um escalar tal que existe um vetor X, com , onde X é chamado de autovetor de A associado a .

Polinômio característico

[editar | editar código-fonte]- Definição

Seja A uma matriz quadrada de ordem n. O polinômio é chamado de polinômio característico de A.

Prove:

- Seja uma base de V, e v um autovetor de T associado ao autovalor . Então é um autovetor da matriz associado ao autovalor de

- Se e são duas bases quaisquer de V, então o polinômio característico de é igual ao polinômio característico de .

Operador diagonalizável

[editar | editar código-fonte]- Definição

Um operador T é dito diagonalizável se existir uma base de V tal que é uma matriz diagonal.

- Definição

Duas matrizes quadradas de mesma ordem, A e B, são ditas semelhantes se existir uma matriz P, de mesma ordem, inversível, tal que .

- Definição

Uma matriz é dita diagonalizável se for semelhante a uma matriz diagonal D (ou seja, existe uma matriz P, inversível, tal que ).

Prove:

- Se são autovetores de T associados, respectivamente, aos autovetores tais que se , então é LI.

- Seja uma base de V. A matriz é diagonal é uma base de V formada por autovetores de T

- Se T é auto-adjunto e é um autovalor de T, então .

- Se T é auto-adjunto e são autovetores de T associados aos autovalores (distintos), respectivamente, então , se .

- Se T é unitário e é um autovalor de T, então .

- Se é um autovalor de T e T é normal, então é autovalor de .

- é T-invariante.

- é -invariante.

- Se T é normal e é autovalor de T, então é -invariante.

- Se T é normal, então é T-invariante.

|

Esta página é um esboço de matemática. Ampliando-a você ajudará a melhorar o Wikilivros. |

Os teoremas espectrais são muito importantes na álgebra Linear, pois garantem a existência de uma base ortonormal de autovetores para alguns tipos de operadores. Como visto, isto implica que o operador é diagonalizável, o que facilita bastante os cálculos.

Teorema espectral para operadores auto-adjuntos

[editar | editar código-fonte]Seja um operador auto-adjunto e V um espaço vetorial complexo ou real de dimensão n. Então existe uma base ortonormal de V formada por autovetores de T.

Teorema espectral para operadores unitários

[editar | editar código-fonte]Seja um operador unitário e V um espaço vetorial complexo de dimensão n. Então existe uma base ortonormal de V formada por autovetores de T.

Nesta página estarão indicadas as convenções adotadas neste wikilivro, no que diz respeito a sua formatação. Recomenda-se a leitura do mesmo, por todos que pretendem contribuir com a melhoria desde texto.

Dicas

[editar | editar código-fonte]- Observações

- Sempre que for dar uma dica ao leitor, utiliza a faixa acima. Isso oferece um destaque à sugestão que estiver sendo dada.

- Esta faixa é criada usando a predefinição

{{CaixaMsg}}.

Definições

[editar | editar código-fonte]- Definição

Uma definição pode ser entendida como o texto que explica de forma precisa o significado de um conceito.

- Observações

- Geralmente um termo importante aparece pela primeira vez em uma definição.

- Devido à sua importância, é bom destacar a definição do restante do texto.

- No momento, a forma de destacar uma definição neste wikilivro é a inclusão da mesma dentro de uma região com bordas duplas, como no exemplo acima. Para isso, utiliza-se a predefinição

{{Definição}}. - O conceito que está sendo definido tem sido colocado em negrito, sendo que o texto da explicação tem sido alinhado a esquerda.

Exemplos

[editar | editar código-fonte]- Observações

- Novamente, utiliza-se a predefinição

{{CaixaMsg}}para posicionar uma faixa azul e uma imagem no lado esquerdo do exemplo. - Note que não há bordas em torno dos exemplos.

Propriedades

[editar | editar código-fonte]- Teorema

Sempre que uma propriedade importante dos objetos tratados no texto precisa ser destacada, isto deve ser feito em uma caixa como essa.

- Observações

- Os principais tipos de propriedades a ser destacados são: teoremas, corolários e pequenos lemas.

- Para conseguir a formatação acima, utiliza-se a predefinição

{{Teorema}}.

Nesta página estão listados os conceitos abordados neste livro em ordem alfabética.

O nome de cada conceito possui um link para a página onde o mesmo é definido. Outras ocorrências importantes do conceito são indicadas pelos links numerados, logo após o link principal.

- Adição

- Adjunta

- Auto-subespaço

- Autovalores

- cálculo

- complexos

- de matrizes reais

- definição

- de matrizes auto-adjuntas

- de matrizes simétricas positivas

- e determinantes

- generalizados

- produto

- sensibilidade

- soma

- Base

- Caminho em um grafo

- Circuitos elétricos

- Codificação de mensagens

- Coeficiêntes de Fourier

- Cofatores

- Combinação

- Comutatividade

- Condições de Penrose

- Cone

- Cônica

- Conjunto

- convexo linearmente

- Distributividade

- Decomposição

- em valores singulares

- Deflação

- Descomplexificada

- Desenvolvimento de um determinante

- Desigualdade

- Deslocamentos da origem (no método das potências)

- Determinante

- do operador descomplexificado

- definição

- e autovalores

- e independência linear

- expansão em cofatores

- menor

- propriedades

- Diagonalização

- Dimensão

- Distância

- Distribuição

- Multiplicação

- Matriz(es)

- coluna

- definição

- diagonal

- escalar

- identidade

- linha

- nula

- quadrada

- triangular superior

- triangular inferior

- Sistema de equações lineares

- Subespaços

- nulo

|

Esta página é um esboço de matemática. Ampliando-a você ajudará a melhorar o Wikilivros. |

|

Faltam capítulos neste índice. |

Livros

[editar | editar código-fonte]- Artin, Michael. Algebra. Englewood Cliffs: Prentice Hall, 1991. 672 p. ISBN 0130047635

- Halmos, Paul Richard. Finite-Dimensional Vector Spaces. Berlin: Springer, 1974. ISBN 0387900934

- Hoffman, Kenneth, Kunze, Ray. Linear Algebra. Englewood Cliffs: Prentice-Hall, 1971. 407 p. ISBN 0135367972

- Hogben, Leslie. Handbook of Linear Algebra. Boca Raton: CRC Press, 2007. 1400 p. ISBN 1584885106

- Jacobson, Nathan. Lectures in Abstract Algebra. Berlin: Springer, 1976. 217 p. v. 1. ISBN 0387901817

- Lang, Serge. Algebra. Berlin: Springer, 2002. 914 p. ISBN 038795385X

- Leon, Steven J.. Álgebra Linear com Aplicações. 4ª.ed. Rio de Janeiro: LTC, 1999. 390 p. ISBN 8521611501

- Lima, Elon Lages. Álgebra Linear. 7ª.ed. Rio de Janeiro: IMPA, 2006. 357 p. ISBN 8524400897

Ligações externas

[editar | editar código-fonte]- Linear Algebra Livro de Álgebra linear no wikilivros em inglês.

- A First Course in Linear Algebra - livro sobre álgebra linear, em língua inglesa, licenciado sob a GNU Free Documentation License.

- Linear Algebra - outra opção de livro em língua inglesa, licenciado sob a GNU Free Documentation License.

- Página do professor Reginaldo (UFMG) - contém diversos livros sobre o assunto.

![{\displaystyle [T]_{\alpha }=(a_{ij}),}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1e06a3098f5c624774677e5a9b2e91f2d558fbd8)

![{\displaystyle [T^{*}]_{\alpha }=({\overline {[T]_{\alpha }}})^{t}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c47f16c51040c5b062b1631d08aaed561c953467)

![{\displaystyle [T]_{\alpha }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/94e60046e037e59417b0dd94d4ddea306cfcfb1c)

![{\displaystyle A=[T]_{\beta },\beta \;}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9f522379ae7bb09fb0b7d893754ea0b3bc97dab0)

![{\displaystyle [v]_{\alpha }\;}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ea894c5b8375f7677e8e7e80cd692281ff5fba7f)

![{\displaystyle [T]_{\alpha }\;}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f077acf42fdf137ecca81a1b3778c12497d197d3)

![{\displaystyle [T]_{\beta }\;}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99038461a79dc9f9848f3ef7ba791126ef2a04f3)

![{\displaystyle W=[u_{1},u_{2}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b518617711bcb6111d25c7103cf92c733d40bbe6)

![{\displaystyle [v]_{\alpha }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e1ed87616ccb5ae96ad4bf4c6ae9a357703dd108)

![{\displaystyle [T]_{\beta }}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e31ef65cd06db3b04d78cf5153d4654a43ee3ec6)